Compagni di Cellula

Modello Cellulare, Fenomenologia, Superamento della Soglia, Energia ed Equità

di

Paolo Lapponi

La Cellula è dunque un sistema “autopoietico” nel dominio biologico-cognitivo. Su scale dimensionali topologicamente differenti, potremo sostenere che tutta l’organizzazione della vita sul pianeta è realizzata sul modello cellulare, con il quale condivide alcune caratteristiche strutturali essenziali, innanzitutto la “membrana permeabile”, che chiamerei in senso lato “capsula permeabile”. Anche il corpo umano possiede queste caratteristiche. Anche il suolo terrestre non cementificato possiede queste caratteristiche. Anche la biosfera possiede queste caratteristiche: la biosfera rappresenta quella esclusiva ed unica “capsula permeabile” entro la quale è possibile la vita nel sistema solare. Per avere un’idea della limitatezza del nostro spazio vitale, la porzione del pianeta contenuta nella sua capsula permeabile in cui possiamo vivere è solamente il 4% della superficie terrestre per un’altezza di circa 10 chilometri di troposfera: se si riduce il pianeta alle dimensioni di un mappamondo da tavolo corrisponde ad un sottilissimo velo di vernice. Tutto qui lo spazio a disposizione per la vita umana.

Occorre perciò tornare a sottolineare come la “permeabilità” della membrana sia una delle chiavi per la comprensione dei meccanismi di una “macchina morbida”, cioè di una struttura vivente in grado di evolvere, di dissipare, di assemblare, di comunicare e quindi di scambiare energia, materia e segnali con l’esterno.

Questa caratteristica è essenziale alle forme di vita che conosciamo perché consente loro di non essere – dal punto di vista termodinamico – né un “Sistema Chiuso” né un “Sistema Aperto”, bensì appunto – sfuggendo a Carnot – di essere un sistema selettivamente permeabile, in quanto tale potenzialmente autopoietico, autogenerante, autoreplicante, in grado cioè di realizzare forme organizzate e strutture emergenti nel contesto dell’irreversibilità cogente del tempo.

Nell’ambito della chimica del Carbonio le membrane a doppio strato lipidico si possono considerare le prime strutture viventi che compaiono sulla terra, poco dopo o addirittura contestualmente alla sua formazione: goccioline di grasso che si formano spontaneamente (autopoietiche) in soluzione acquosa e che possiedono la capacità di essere appunto “selettivamente” permeabili.

Il nostro corpo è formato da strutture molto più evolute delle primitive goccioline di fosfolipidi apparse 4 miliardi di anni fa. La cellula eucariote, dotata di nucleo contenente il DNA , è comparsa molto più tardi, circa 1.5 miliardi di anni fa, quando, sia la biosfera del nostro pianeta, sia il ciclo notte/giorno si stavano lentamente stabilizzando. La sua apparizione rappresenta un punto di arrivo talmente decisivo del percorso evolutivo che viene spesso denominata “la rivoluzione della cellula eucariote”. La sua complessità non è descrivibile in poche parole. Watson insieme ad altri autori le dedicano un intero volume di 1200 pagine, “La biologia molecolare della Cellula”, magistralmente tradotto ed edito da Zanichelli, prima edizione italiana 1984.

Ciò che ora mi interessa però sottolineare è una caratteristica particolare di questa cellula complessa, proprio quella cellula che Pirsig – con la libertà concessa linguisticamente al romanziere – immagina dotata di “intelligenza”. Per descrivere questa caratteristica credo sia utile avere a portata di mano il testo proposto da Francisco Varela “Neurofenomenologia”, nella specifica parte in cui affronta la “riduzione”, e in particolare nella sua analogia con il “dubbio”. Per quale motivo? Perché “l’intelligenza” di una cellula eucariote può funzionare solamente con meccanismi dotati di un certo grado di “imprecisione”. Quella che a me piace chiamare una “macchina morbida” ha cioè un bisogno imprescindibile di poter “sbagliare”, nella sua stessa natura è obbligatoriamente iscritto l’”errore”, nella sua dinamica del disequilibrio è necessario inserire una variabile nuova, la “trasgressione”: una serie linguistica e terminologica che allude facilmente alla condizione umana tipicamente imperfetta dello “stato del dubbio”.

Torna utile descrivere brevemente la complessità della nostra forma di vita. Per far questo il sistema biologico che a me sembra più indicato è il “sistema immunitario”: perché è il sistema naturale di riconoscimento della singolarità umana, l’individuo specificamente “tipizzato”; perché allo stesso tempo è un sistema di difesa e d’identificazione somatica corpo-mente. Il sistema immunitario – peraltro tra i più conosciuti fra i sistemi biologici complessi – origina dai primi “cordati”, evolve nei vertebrati marini (i primi ad avere un sistema gruppo/sanguigno sono pesci simili alla Lampreda), ed esplode infine in tutta la sua potenza nei mammiferi superiori.

Il sistema immunitario evolve a livello midollare contestualmente al sistema neurale con il quale condivide connessioni strettissime che comunicano con il cervello. Allo steso modo esso è connesso al sistema endocrino che pure alloca in precise aree del cervello i suoi meccanismi di regolazione.

Il primo grande studioso moderno del sistema immunitario è il premio Nobel MacFarlane Burnett, dell’Università di Sidney, che negli anni 60 utilizzerà per la prima volta il termine “network” per descrivere l’architettura di un sistema complesso vivente ad altissimo rendimento. Dunque la prima Rete sistemica e complessa, evoluta dalla lunga storia dei vertebrati, abita nel nostro stesso corpo.

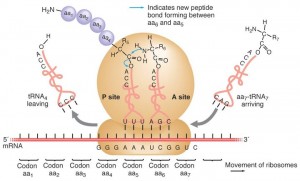

Per avere una modesta idea della sua efficienza: dall’inizio del contatto infettivo alla reazione immunitaria in un brevissimo lasso di tempo ogni Ribosoma di un linfocita B assembla a pieno regime un’immunoglobulina ogni 30/40 secondi. In un linfocita B si possono attivare centinaia di Ribosomi tutti contemporaneamente impegnati nella realizzazione della stessa immunoglobulina. Una risposta immunitaria efficace metterà in campo migliaia di linfociti B preposti dalla precedente memoria timica alla produzione simultanea di uno specifico anticorpo monoclonale in milioni di esemplari.

La catena di montaggio inizia con l’apertura e la lettura del “gene” all’interno del nucleo; prosegue con la trasmissione del messaggio per mezzo dell’RNA messaggero il quale comunica il segnale all’esterno del nucleo; continua con la traduzione del messaggio a livello dei Ribosomi i quali disposti sull’apparato di Golgi assemblano gli amminoacidi in una proteina completa (o quasi completa) al ritmo di una ogni 30 secondi.

Contemporaneamente nel citoplasma si attivano i processi che provvedono alla disponibilità di amminoacidi allo stessa velocità con la quale essi vengono incorporati nella proteina. Milioni di IgG al minuto attraversano allora la “membrana permeabile” riversandosi nella corrente sanguigna all’attacco dello specifico bersaglio non self. Allo stesso tempo la temperatura corporea sale intorno ai 40°C come ulteriore meccanismo termico di attacco all’antigene: questa è più o meno la massima dissipazione calorica della nostra “macchina morbida”.

La coordinazione di tutti i reparti coinvolti, il sistema di segnaletica on/off, i meccanismi a retroazione che regolano i flussi, lo stop and go degli “operon” disvelati da Monod, l’incredibile rapidità della comunicazione elettrochimica neuro/endocrino/immunitaria, la stupefacente velocità di tutta questa complessità biomeccanica, dinamica e tridimensionale è tale da rimanere attoniti, è tale da far girare la testa.

Un Ribosoma Linfocitario assembla un’IgG in 30′

Questo rapidissimo flash in primo luogo suggerisce un’immagine quasi statica del DNA, il quale viene processato, manipolato, tagliato, cucito e infine rimpacchettato: la vera complessità sistemica non appartiene tanto al DNA, bensì alle cellule, alle loro membrane, ai loro apparati interni e alle connessioni neuro/endocrine.

In secondo luogo è facilmente immaginabile come un meccanismo di tale complessità e di tale velocità di funzionamento possa autogenerare “errori”, o possa essere indotto all’errore da una moltitudine di agenti endogeni o esogeni, fisici, chimici ed emozionali. Ciò spiega peraltro il noto fenomeno della variabilità.

Ora se io immagino un’intelligenza artificiale, una rete neurale, una “macchina dura” con capacità di “apprendimento” e dotata di linguaggio, essa per analogia e per sua stessa natura dovrà essere egualmente provvista di un certo grado di “imprecisione”. Le primitive reti neurali in grado di “apprendere” realizzate da Domenico Parisi contenevano già questo principio. E, per quanto ne so, questa strada sperimentale è tutt’ora ampiamente battuta.

Ma a questo punto mi interessa spingere a fondo questo concetto dell’imprecisione molecolare, dell’inevitabilità dell’errore, della possibilità di sbagliare sussunta nella materia biologica – qui è racchiusa per me la grande suggestione del “libero arbitrio” che riporta all’imperfetta condizione umana dello “stato del dubbio”. Qualcuno ha usato addirittura il termine “sovversione” per indicare un carattere insopprimibile dell’emergenza, che ha origine dalla nascita del Tempo ed evolve fino alla coscienza.

D’altronde – ed eccoci ad un altro punto chiave – un sistema autopoietico che produce “errore” deve possedere anche un adeguato dispositivo di riparazione/manutenzione. Questo dispositivo è a sua volta un “sistema complesso” che agisce con modalità multitasking su tutti i sistemi attivati dalle funzioni metaboliche.

L’equilibrio tra errore e riparazione è definibile innanzitutto da un rapporto quantitativo, ovvero quantità di errore/capacità di riparazione. Il numeratore di questo rapporto nel corso della vita umana subisce un incremento irreversibile, il cui risultato – dovuto all’eccessivo accumulo d’errore – è la malattia e infine la morte. Superata una determinata “soglia” il dispositivo riparatore va in tilt, l’efficacia del sistema immunitario diminuisce, la cellula neoplastica – la malattia per antonomasia – prende il sopravvento.

Per inciso, a questo proposito è essenziale accennare all’importanza di quella situazione particolarissima del ciclo giorno/notte causata dal moto planetario la quale incide primariamente sui dispositivi di riparazione delle forme viventi eucariote pluricellulari superiori, sia nel mondo vegetale che in quello animale: è la condizione del dormire. La diminuzione delle ore di sonno e le difficoltà nel dormire riflettono, nella vita umana con l’avanzare dell’età, il minor rendimento dei dispositivi di riparazione.

Il superamento di una determinata “Soglia” [che ha nel concetto di massimo/minimo il suo equivalente matematico in topologia differenziale], il superamento di un “cut-off” rispetto all’accumulo di errore è dunque un momento significativo nella complessità dei sistemi viventi. Renè Thom analizza questi momenti culminanti descrivendo 7 archetipi, o tipologie morfogenetiche di catastrofi. Nulla di sorprendente se una delle forme di catastrofe analizzata da Thom è a livello della “gastrula”, cioè della nascita. La nascita di una struttura emergente, la nascita di una forma vivente è una catastrofe, così come lo è la sua morte. La storia del nostro pianeta, la storia dei sistemi viventi che esso ospita, la storia della nostra stessa vita – ontologicamente e filogenicamente – è dunque una storia costellata inevitabilmente da catastrofi. Cioè da un periodico e ciclico superamento della Soglia.

È opportuno aprire qui un’importante parentesi per chiarire una volta per tutte una sorta di “equivoco” tra il concetto di “macchina morbida” e le cosiddette Biotecnologie. L’avvento del potere postgenomico, cioè una tecnologia politica che stabilisce un potere bioeconomico sulla vita ha generato in pochissimi anni un mercato globale di massicci investimenti in campo farmaceutico, diagnostico, agricolo, genetico. Una sentenza della Corte Suprema USA ha consentito che anche ingenti risorse pubbliche venissero ricanalizzate dalla ricerca sul cancro all’industria biotecnologica. L’equivoco cui accenno ha il suo culmine nel finanziamento del Progetto Genoma che ha a che fare con una visione riduzionista dei sistemi viventi. Infatti “l’intelligenza” delle cellule, la vera complessità sistemica non è esclusivo appannaggio del DNA, del Genoma, tutt’altro. Essa compete all’insieme dei sistemi cellulari, alle loro membrane, ai loro apparati interni e alla vastissima complessità delle connessioni neuro/endocrine.

Due sono i momenti decisivi per l’esplosione dell’ingegneria genetica: il 1973 con la scoperta degli enzimi di restrizione che tagliano e ricombinano il DNA; il 1983 con la messa a punto della PCR (Reazione a Catena della Polimerasi) da parte di Kary Mullis che permette la riproduzione in provetta di DNA dallo stesso DNA, cioè senza la necessità di una cellula viva. Due anni più tardi Gilles Deleuze scriveva:

“È stato necessario il salto della Biologia nella Biologia Molecolare, oppure che la vita dispersa si raccogliesse nel codice genetico. È stato necessario che il lavoro disperso si raccogliesse o si raggruppasse nelle macchine della terza generazione, cibernetiche e informatiche” … “A costituire allora il meccanismo operativo non sarebbero né la piega né il dispiegamento, ma qualcosa come una “superpiega”, di cui ci testimoniano i piegamenti propri alle catene del codice genetico, le potenzialità del silicio nelle macchine della terza generazione, così come i contorni della frase nella letteratura moderna allorché il linguaggio “può solo solo ricurvarsi in un perpetuo ritorno su di sé”.

La trasformazione introdotta dalle biotecnologie e la loro conseguente enorme capitalizzazione ha prodotto allora uno spostamento nel rapporto tra vita e politica che, a partire da Foucault, ha visto la nascita della critica alla bio-politica moderna. Seppur profonda e pregna di significato anticipatorio, la critica foucaultiana al dispiegarsi del potere capitalistico contemporaneo alla società biopolitica essa sembra poggiarsi proprio sull’equivoco riduzionista: un gene=un enzima. Oggi ne sappiamo abbastanza per poter dire che da uno stesso gene si possono realizzare centinaia di proteine diverse per successive procedure di assemblaggio.

L’equivoco sorge dall’idea che il DNA contenesse il dogma, quando invero così non è. L’equivoco s’incarna dunque, come detto prima, nel progetto Genoma, che ha dato spazio infine alle deliranti affermazioni di Craig Venter sulla “vita artificiale”.

Ma è corretto paragonare tout court corpo, mente e complessità sistemica del vivente, apprendimento, linguaggio ed elaboratori meccanici? Il confronto tra i paradigmi della complessità del vivente ha bisogno di una visione molto più estesa che deve fare i conti con le nuove ipotesi della Scienza della Vita, nello scenario in cui agiscono appunto le “macchine morbide”, che è impossibile ridurre esclusivamente al codice genetico. In questo scenario la linea di indagine che procede, interdisciplinarmente e dialetticamente, da Maurice Merleau-Ponty, a Prigogine, a Bateson a Maturana, a Varela, a Margulis e tanti altri si contrappone appunto ai dogmi imposti dalla centralità di un Codice, privilegiando invece l’emergenza e l’imperfezione.

Ogni tentativo – nella Società della Conoscenza – di evitare il confronto con la complessità del vivente si scontra innanzitutto con il problema del Rendimento. Al nostro livello di sviluppo tecnologico il rendimento di una “macchina morbida” è centinaia di volte più elevato di quello di una “macchina dura”, è sufficiente confrontare l’enorme differenza di dissipazione calorica. La mente umana, il cervello, lavora a una temperatura di circa 37°C . Una CPU al silicio di ultima generazione ha bisogno di raffreddamento liquido forzato per non fondere.

Conseguentemente quest’ultima è centinaia di volte più vicina al collasso. Uno degli anelli deboli della macchina dura va ricercato senz’altro nella mancanza di adeguati dispositivi di riparazione/manutenzione. Questi dispositivi, per analogia e comparazione con il funzionamento e con il rendimento di una “macchina morbida”, possono esistere soltanto in strutture emergenti realizzate con architettura sistemica a Rete orizzontale, flessibile, permeabile e distribuita. E soprattutto iniziando ad analizzare la possibilità di “macchine biosomiglianti”, basate cioè non più sul Silicio, ma bensì proprio sul Carbonio – a questo proposito la recentissima apertura al “Grafene” mi sembra di grande importanza.

Eppure la potenza delle “macchine dure” nella fase del più alto sviluppo tecnologico mai raggiunto dalla società umana è un enorme e inedito interrogativo per il sistema vivente collettivo, per Gaia e per la sua sopravvivenza. Infatti, l’esplosione e lo sviluppo delle tecnoscienze da una parte riflette la la potenza raggiunta dal Capitalismo industriale mondializzato secondo la logica del massimo profitto; dall’altra e paradossalmente rispecchia il suo stesso irreversibile declino in uno scenario di crisi e di trasformazione epocale, causato in un’ultima analisi proprio dal superamento della Soglia e dall’inesistenza di meccanismi di riparazione e di regolazione. Perché? Proprio perché la potenza delle tecnoscienze sviluppata sulla logica del mercato Capitalistico non è una struttura emergente realizzata con architettura sistemica a Rete distribuita. E’ accumulazione forzata ad architettura e gerarchia verticale sulla quale sono modellati tutte le Istituzioni della Società Industriale basata sulla crescita del PIL, comprese le sue Istituzioni della Conoscenza, comprese le sue Istituzioni sindacali di difesa del lavoro industriale, compresa la drammatica potenza di Hiroshima, compresa la NASA e la conquista del suolo lunare.

Osserviamo così l’avanzare di una crisi epocale come un treno in corsa che nessuno è in grado di fermare non possedendo strumenti per affrontare il superamento della Soglia, e che consuma molta più energia di quanti beni sia in grado di produrre: il suo rendimento è bassissimo e il prezzo da pagare è quindi altissimo e tutto in perdita. Ma il guaio maggiore è che si tratta di un prezzo “sociale”. Natura, corpi e menti pagano un’immensa dispersione di energia il cui esito finale può essere solamente altamente catastrofico.

L’enorme squilibrio economico, che è squilibrio tra vita e vita, tra fame e sazietà, tra dignità e offesa, tra pensiero ed insipienza, è il corollario dello sviluppo di un mondo che ha cessato di ricrearsi. Esso non rinnova più né la propria esistenza né il proprio senso, e travalica invece, con la hybris e per necessità insieme i suoi stessi limiti verso l’illimitatezza della propria mondialità, in modo tale che questa sembra non poter che implodere o esplodere. Jean- luc Nancy, in “Globalizzazione, libertà e rischio” (MicroMega, (5), 2001, pp. 101-107)

____________________

Bibliografia essenziale

“Biologia Molecolare della Cellula” – James D. Watson, Zanichelli, 1984 (1° edizione)

“Dalle macchine termiche alle strutture dissipative” – Ilya Prigogin, Bollati Boringhieri, 2002

“Intervista sulle reti Neurali” – Domenico Parisi, Il Mulino. 1989

“Mutazioni o Rivoluzioni” – Judith E. Sclanger, Lerici, 1980

“Self and not-self” – F. Macfarlane Burnet, Zanichelli, 1974

“Il caso e la necessità” – Jacques Monod, Mondadori, 1970

“Modelli matematici della morfonogenesi” – René Thom, Einaudi, 1985

“Il potere biotecnologico” – Roberto Ciccarelli, Quodlibet, 2008

“Energia ed Equità” – Ivan Illich, 1975

“Symbiotic Planet” – Lynn Margulis, Basic books, 1998

I commenti a questo post sono chiusi

yes!

L’autore non ha certo studiato molti dei libri messi in bibliografia, altrimenti non scriverebbe un pezzo così pieno di imprecisioni o veri e propri errori…

andrea sarebbe interessante indicare precisamente dove e come. Magari l’autore potrebbe a quel punto replicare, no? io così intendo la discussione. E comunque soprattutto quando ci si avventura su campi minati è più che naturale rischiare di fare passi falsi.

effeffe

Concordando con quanto scrive Francesco Forlani, l’autore ritiene modestamente che questa nota potrebbe anche essere titolata “Elogio dell’errore”; dunque ben venga la critica all’errore, è da lì che si parte … magari con un poco più di dettagli si potrebbe proficuamente approfondire, che è il cammino desiderato.

Aggiungo alcuni brani, a parer mio di grande interesse esplicativo, estrapolati da un notevole saggio di Ignazio Licata:

“Si può ben vedere come un’impostazione [cognitivista] richiami il cartesian cut tra mente e materia, e stabilisce una separazione piuttosto netta tra informazione ed energia, che invece in natura sono sempre strettamente connesse attraverso processi dissipativi che permettono una continua elaborazione e riorganizzazione dell’informazione, ma soprattutto l’acquisizione e la produzione di nuova informazione. Si è assunto per lungo tempo che il modello della Turing-Computabilità potesse rendere conto degli aspetti delle computazione biologica, che appare invece richiedere un approccio teorico nuovo visto che i sistemi naturali mostrano contemporaneamente aspetti sub & super Turing, in grado di lavorare efficacemente anche in situazioni di rumore, incompletezza e fuzziness attraverso sofisticate procedure di appropriazione semantica dell’informazione. … L’idea di ampliare lo “spessore semantico” dell’informazione utilizzata dal sistema ampliando lo scenario (regole, descrizione) porta ad alcuni aspetti paradossali. Infatti, se anche fosse possibile includere nel nostro modello ogni dettaglio della descrizione del mondo, ed ogni possibile azione su di esso, questo significherebbe che il sistema è strettamente deterministico, in aperto contrasto con ciò che conosciamo dei processi biologici e della cognizione naturale. … Gli approcci connessionisti, basati sulle reti neurali e sui sistemi distribuiti paralleli, hanno aperto nuovi scenari legati ad una diversa e più stretta relazione tra sistema ed ambiente che può essere colta utilizzando l’approccio sistemico-cibernetico, sviluppato tra gli altri da N. Wiener, L. Von Bertalanffy, R. Ashby, H. Von Foerster,, H. Maturana e F. Varela. In questo caso non si dà descrizione del mondo senza considerare l’osservatore, sistema che interagisce con altri sistemi e seleziona l’informazione in relazione alla sua struttura interna, ed alla sua storia dinamica. Tra osservatore (sistema intelligente) ed osservato ( mondo ), non c’è più una relazione lineare e deduttiva, fissata una volta per tutte in un modello formale, ma una relazione circolare basata su una strategia di adattamento e coevoluzione continua. Questo implica almeno due differenze notevoli con l’approccio cognitivista sopra delineato. Innanzitutto è necessario considerare una relazione di apertura termodinamica tra sistema ed ambiente. Informazione ed energia costituiscono un flusso che attraversa e ridefinisce continuamente le relazioni e la struttura di entrambi. Questa è una condizione necessaria ma non sufficiente, riassumibile dicendo che un sistema intelligente deve essere un sistema dissipativo. Inoltre è necessario che il sistema possieda apertura logica, ossia esibisca comportamenti emergenti legati allo stato dinamico delle relazioni sistema-ambiente, in grado di pilotare il sistema verso situazioni adattive sempre più complesse attraverso la produzione di nuova informazione.”

“Web semantico”, Ignazio Licata (ISEM): si apre una nuova era di connessioni tra la ricerca pura e le applicazioni avanzate. 6 aprile 2010

Non che io non abbia aprrezzato l’articolo e lo sforzo fatto per rendere comprensibile un argomento ostico come la biologia molecolare della cellula e l’immunologia, ma frasi come questa sono, nel caso migliore, confusissime e nebulose, nel peggiore completamente sbagliate: l”Una risposta immunitaria efficace metterà in campo migliaia di linfociti B preposti dalla precedente memoria timica alla produzione simultanea di uno specifico anticorpo monoclonale in milioni di esemplari.”

Che cosa sarebbe la memoria timica? Se si intende la memoria delle cellule T (che maturano nel timo), questa è indipendente dalla memoria delle cellule B, che maturano nel midollo osseo, e lì tornano come plasma cellule, ovvero le cellule che secernono gli anticorpi. Le cellule B della memoria risiedono negli organi linfoidi e possono essere riattivate anche indipendentememnte alle cellule T.

L’affermazione che il DNA nn contenga il dogma è secondo me non corretta: nasce forse dall’idea che con il sequenzamento del genoma avremmo trovato spiegazione/cura per molte malattie. Il problema è che si sta imparando che certi fenomeni che originano dal DNA o lo modiicano, come microRNA e modificazioni epigenetiche, sono altrettanto importanti, ma non siamo in grado di apprezzarle solo dal sequenziamento (tra l’altro si è sempre pensato che il DNA importante fosse quello che codifica i geni, che è una piccola percentuale, tanto che l’altro è chiamato junk DNA).

Il rifiuto dell’approccio riduzonista nelle scienze biologiche è affascinante, ma dal punto di vista di uno scienziato come me significherebbe rinunciare totalmente alla sperimentazione in vitro (visto che mancano tutti i network presenti in vivo) ed ampliare moltissimo la sperimentazione animale, con costi economici crescenti ed interrogativi etici non da poco.

La prima cortese critica di Andrea è senz’altro giusta, e lo ringrazio.

Per eccessiva esemplificazione ho scritto un’imprecisione, un “errore” appunto, seppur parziale e riscontrabile da specialisti. Infatti. E’ comunque un’evidenza che la memoria timica è parte essenziale dei meccanismi reticolari e interconnessi della memoria immunitaria, la quale ultima avrebbe bisogno di una ampia visione generale. Anzi, sulla memoria immunitaria bisognerebbe aprire un capitolo a parte, tanto è rilevante la sua importanza epistemica ed evolutiva. Ed è pur vero che essendo i linfociti B precursori delle Plasmacellule, la mia seconda semplificazione penso possa essere accettata. Peraltro anche la mia descrizione dei meccanismi che portano l’informazione dal gene al ribosoma è estremamente semplificata, ed anche lì si possono trovare passaggi al limite dell’imprecisione. Ma tuttavia ciò non fa che dare più forza all’intero ragionamento, perché più si scende nel dettaglio, più la complessità dei meccanismi cellulari aumenta. E si rimane infine ancora più attoniti.

Per quanto riguarda il ruolo del DNA e la sua posizione nella complessità del vivente il discorso è invece diverso. Eravamo studenti nell’epoca della scoperta della doppia elica, e non dimentico il fascino delle prime affollatissime lezioni di Aldo Spirito alla Sapienza di Roma (ultimi anni 60). Non metto in dubbio quindi l’assoluta importanza del disvelamento del codice e il conseguente nuovo grandioso scenario che da quel momento si presentò ai biologi e al mondo. Da allora sono però passati quasi cinquant’anni e molte altre cose sono accadute con la nascita di scuole di pensiero diversificate e multidisciplinari, con l’avvento delle scienze della complessità.

Di una di queste diversificazioni è precursore lo stesso Aldo Spirito che già nel 1949 così si esprimeva: “prendere contatto con i problemi più vari della vita, sì da conoscere orizzonti più ampi in cui concretare le proprie ricerche, coordinandole poi tutte insieme in una concezione di carattere generale.”

Nel 1979 Aldo Spirito lascia la direzione della “Rivista di Biologia” che da quel momento si rinnova profondamente, cambiando orientamento, organizzazione editoriale, collaboratori e trasformandosi in periodico internazionale di frontiera. L’editoriale del primo numero del 1981 ( a firma di Giuseppe Sermonti) offre alla discussione due paradossi, la cui soluzione non è nel DNA: perché la vita è stabile? Perché il verme è verme e la balena è balena? Vi appaiono presto alcuni articoli importanti. B.C. Goodwin e G.C. Webster prospettano una teoria generativa della morfologia e delle sue trasformazioni, sviluppando il concetto di organismo come struttura autorganizzata (teoria del campo morfogenetico). E. Samek Ludovici (“La gnosi e la genesi delle forme”) rileva l’atteggiamento gnostico nella teoria neo-darwiniana. La pubblicazione di una corrispondenza Waddington–Thom apre la Rivista alla biologia teorica e introduce nozioni come la Dinamica della morfogenesi (Thom) e la Canalizzazione dello sviluppo (Waddington). Poi entra in scena A. Sibatani (“Two phases of molecular biology”) che propone (dopo la rivoluzione molecolare) una trasformazione della ontogenesi, al di là della genetica e della specificità molecolare.

Personalmente non condivido le ipotesi devoluzioniste di Sermonti. Tuttavia il suo percorso ha momenti di importante confronto, non solo con Renè Thom e poi con la scuola di Osaka. Qui soprattutto mi interessa sottolineare il suo incontro ravvicinato con Ivan Illich, sul quale ultimo vorrei poi ritornare.

Mi interessa piuttosto insistere sul graduale riposizionamento del DNA nella complessità dei sistemi viventi. E’ audace affermare che il DNA non è il Dogma? Probabilmente si, ed è anche volutamente provocatorio. Tuttavia, non si toglie nulla all’importanza del DNA se lo si paragona alla decisiva invenzione dell’Alfabeto nell’accezione che ne fa Gadamer (forzatura, oh yes!). I circa 22 segni alfabetici rappresentano la rivoluzione di cui ci fa dono il medioevo antico, contestualmente all’inizio dell’età del ferro. Questo dono produrrà l’Iliade e tutto il resto. Ma la complessità emergente risiede nella scrittura e nel linguaggio, non nell’alfabeto – anche se esso risulta indispensabile. Mi permetto allora di formulare un’altra analogia audace: in qualche maniera le triplette del Codice hanno una corrispondenza con l’alfabeto, esse sono indispensabili, ma non è lì che risiede la complessità emergente del vivente. Non è l’alfabeto che evolve, bensì il linguaggio; non sono le triplette che si modificano, bensì le strutture emergenti della vita. E dunque per il suo stesso ruolo, il codice racchiuso nel DNA – come l’alfabeto – ha bisogno di una sua “stabilità” storica, per questo è così protetto all’interno del “cromosoma”, per conservare la sua stabilità, che è anche rilevata dalla sua scarsa reattività chimica e dalla sua struttura ”conservatrice”. A incoraggiare questa mia audacia, l’immagine fornita da Deleuze è illuminante:

“qualcosa come una “superpiega”, di cui ci testimoniano i piegamenti propri alle catene del codice genetico, le potenzialità del silicio nelle macchine della terza generazione, così come i contorni della frase nella letteratura moderna allorché il linguaggio “può solo ricurvarsi in un perpetuo ritorno ritorno su di sé”.

Ecco così precisamente descritto un Nastro di Moebius.

Si potrebbe andare avanti a lungo, ma queste riflessioni mi sembrano anche introduttive all’ultima critica sollevata da Andrea, e cioè che un approccio non riduzionista comporterebbe la “rinuncia alla sperimentazione in vitro”. E perché mai? Personalmente sono un appassionato della sperimentazione chiamiamola così “in vitro”, sono un appassionato della tecnologia, almeno per come l’ho vissuta io, negli anni in cui la tecnologia era ancora in rapporto “creativo” con la ricerca, non era ancora completamente “silicizzata”. Similmente a come ne parla Robert Pirsig ne “L’arte della manutenzione della motocicletta”.

Il passaggio all’automazione digitalizzata ha fatto letteralmente dimenticare una quantità di manualità di Laboratorio secondo me preziose, perché potenzialmente non riduzioniste, perché contenevano una “qualità” artigiana indispensabile al ricercatore, come in quella magnifica accezione che ne fa Ruskin contemplando le Pietre di Venezia.

Oggi in laboratorio chi sa più realizzare con la sua manualità una pipetta in vetro sottile quanto occorre per depositare una gocciolina di 200/300 microlitri? O una serpentina di raffreddamento, magari per un particolare Southern Blot? Chi sa miscelare ancora 4 diverse soluzioni tampone a sfumature di Ph in una colonna di cristallo per Cromatografia Liquida? In quale testo è descritta la sottile sapienza di una procedura manuale come una “Limiting dilution” Chi conosce più la lunga procedura manuale di una “immunoelettroforesi” su gel? La lettura dell’occhio umano, la sua insostituibile ed imperfetta esperienza, la sua capacità di valutare le sfumature, in moltissime procedure tradizionali tra cui la microscopia, e così via; ovvero la convivialità del rapporto del medico di tradizione umanista con il paziente … quanto si sta perdendo con l’avanzare dell’infallibilità della macchina, dell’automazione, della specialistica, del condizionamento del mercato e del suo dominio, quanto si sta perdendo in termini di rapporto tra gli umani e con la natura!

“Passare dalla produttività alla convivialità significa sostituire a un valore tecnico un valore etico, a un valore materializzato un valore realizzato. La società conviviale riposerà su contratti sociali che garantiscano a ognuno il più ampio e libero accesso agli “strumenti” della comunità alla sola condizione di non ledere l’eguale libertà altrui. Chiamo società conviviale una società in cui lo “strumento” moderno sia utilizzabile dalla persona integrata con la collettività e non riservato ad un corpo di specialisti che lo tiene sotto il proprio controllo. Conviviale é la società in cui prevale la possibilità per ciascuno di usare lo “strumento” per realizzare le proprie intenzioni.” Ivan Illich, 1975

Ed è proprio alle problematiche dei ricercatori contemporanei, per una nuova metodologia della Scienza, che si dedica particolarmente Francisco Varela nel suo fondamentale saggio “Neurofenomenologia”. Un saggio scritto pochi anni prima della sua scomparsa, con un taglio decisamente anti riduzionista. Proprio laddove egli insiste per un “ri-apprendimento” dei ricercatori in ogni campo della scienza, un nuovo approccio antropologico aperto ad altre culture e saperi.

“La seconda sfida lanciata dalla mia proposta è quella dell’esigenza di trasformazione dello stile e dei valori della stessa comunità dei ricercatori. Se non accettiamo il fatto che, a questo stadio della nostra storia intellettuale e scientifica, è necessaria una sorta di ri – apprendimento radicale, non possiamo sperare di fare un passo avanti e spezzare la ciclicità storica di fascinazione – rifiuto della coscienza nella filosofia della mente e nella scienza cognitiva ….. Ma questo può verificarsi solo se l’intera comunità dei ricercatori riesce a modificarsi (con un cambio di atteggiamento in parallelo rispetto alle forme di argomentazione accettabili, ai criteri di selezione dei contributi e alle politiche editoriali delle principali riviste scientifiche) in modo tale che questa competenza aggiuntiva diventi una dimensione essenziale per un giovane ricercatore. Per l’inveterata tradizione della scienza oggettivista tutto ciò suona come un anatema, e in effetti lo è. Ma non si tratta di un tradimento della scienza: è una sua necessaria estensione e integrazione. La scienza e l’esperienza si vincolano e si modificano a vicenda come in una danza. Ed è qui che giace il potenziale per la trasformazione. E qui si trova anche la chiave degli ostacoli che questa posizione ha trovato all’interno della comunità scientifica, poiché ci chiede di abbandonare una certa immagine di come si fa scienza, e di mettere in discussione uno stile di addestramento scientifico che è una parte importante della costruzione della nostra identità.”

Francisco Varela, “Neurofenomenologia – Una soluzione metodologica al “problema difficile””, Pluriverso, Biblioteca delle idee per la civiltà planetaria, 1997

Mi sono segnato gli autori che cita (Varela e Sermonti li conoscevo) e leggerò i testi al più presto. Vorrei solo aggiungere una cosa: quando leggo riflessioni sulla scienza fatte da non scienziati o scienziati non più attivi nel campo d’indagine, ho quasi sempre l’impressione che una semplificazione massiccia venga fatta per sostenere le proprio tesi.

Ad es. il suo paragrafo sullo scomparire di tecniche di laboratorio mostra un paio di evidenti difetti. Primo, fa una generalizzazione sbagliata: almeno negli US un laboratorio di immunologia buono (come quello in cui sono) pretende che si sappiano fare Southern, Western e immunoelettroforesi, così come cromatografia, almeno per affinità o esclusione molecolare. E sebbene si possano comprare kit già pronti all’uso, per abbassare i costi PhD e postdoc si preparano tutto da zero, partendo da polveri e pHmetro. Oltretutto sapere come si fa materialemente una di queste tecniche è essenziale per capire come funzionano: la percentuale di acrilammide o agarosio non è specificata, è necessario ricavarsela dalla conoscenza della tecnica richiesta.

Secondo, nell’elenco ci sono cose importanti da sapere per uno scienziato (come quelle sopra descritte, e le posso assicurare che il 95% degli scienziati le conosce) e cose pressochè inutili come la pipetta di vetro sottile per 200 microlitri (volume abbastanza ridicolo quando giornalmente si ci muove tra gli 0.5 e i 10 microlitri). Sembra più un sentimento nostalgico per la bella età dell’oro: il mio professore di Cristrallografia all’Univ di PD ci raccontava che ai suoi tempi risolvevano le trasformate di Fourier a mano, con carta e penna, mettendoci mesi, e non finiva di benedire i computer che avevano accelerato la ricerca di anni. Generalmente poi il problema non è che le nuove generazioni di scienziati perdono le basi, quanto che le vecchie non riescono a stare al passo con i tempi. Moltissimi genetisti classici si sono persi di fronte alla genomica (vuoi per la complessità o la necessità di nuove competenza quali la bioinformatica e la biostatistica) così come ottimi ricercatori biomedici ignorano le possibilità date da topi reporter e microscopia a 2 fotoni (ah, la microscopia classica è ancora massivamente usata, personalmente passo al microscopio almeno il 30% del mio tempo).

Potrei continuare oltre, ma mi sembra che una visita annuale a 5-10 laboratori all’avanguardia potrebbe aiutare anche alla formulazione di idea che nn risentano di concetti ormai passati o di pregiudizi.

una domanda a entrambi. Personalmente trovai molto interessante la polemica scoppiata più di una decina di anni fa, nota come l’affaire Bricmont Sokal. Per sintesi riporto qui la quarta di copertina dell’edizione italiana delle Imposture intellettuali uscite da Garzanti:

Questo saggio, che ha scatenato una feroce polemica nelle comunità scientifiche e filosofiche delle due sponde dell’Atlantico, nasce da una beffa. Un giovane fisico, Alan Sokal, invia alla prestigiosa rivista americana «Social Text» un testo dal titolo Trasgredire le frontiere: verso un’ermeneutica trasformativa della gravitazione quantistica, infarcito di insensatezze e di strafalcioni ripresi da alcuni «grandi» del pensiero contemporaneo, in particolare francesi. Anche la tesi di fondo di Trasgredire le frontiere, ispirato a un estremistico relativismo post-modernista, è filosoficamente e scientificamente delirante. Dopo la pubblicazione, Sokal esce allo scoperto, dando inizio a una vera e propria resa dei conti.

Imposture intellettuali trasforma la beffa in un’argomentata polemica contro la faciloneria di molti maestri del pensiero contemporaneo, i quali si sono appropriati di concetti fisici e matematici – senza assolutamente capirli – per costruire ipotesi filosofiche alla moda: usando ampie (e ridicole) citazioni di Jacques Lacan, Julia Kristeva, Luce Irigaray, Bruno Latour, Jean Baudrillard, Gilles Deleuze, Félix Guattari e Paul Virilio, Sokal e Bricmont dimostrano che, dietro un gergo astruso fino al terrorismo culturale e a un’apparente erudizione scientifica, il re è nudo.

In effetti all’uscita di quel libro ci furono soprattutto in Francia delle repliche assai argomentate a difesa dei filosofi. Anche da parte degli uomini di scienza. Ecco, mi faceva piacere sapere, nel caso in cui aveste all’epoca affrontato l’argomento, che idea ve n’eravate fatta

effeffe

Intervenire in questa discussione tra scienziati è per me, che nel campo sono un profano e un dilettante, una grossa presunzione. Mi permetto però di farlo non solo perché invitato da mio fratello, ma anche perché a loro volta spesso gli scienziati sconfinano un po’ in campi non propriamente “scientifici” – nel senso tradiizonale di questa parola. Quando si parla di “cognitivismo”, con esplicita allusione a Cartesio, si entra evidentemente in filosofia, e lo stesso quando si parla di “interrogativi etici”, o si condanna la “logica del massimo profitto” di un certo “capitalismo”. Entrando in questi campi spesso lo scienziato, forse senza avvedersene, continua il suo discorso con la stessa sicurezza a lui abituale quando elabora dati di laboratorio, mentre i dati di laboratorio ormai li ha lasciati alle spalle. Così, ad esempio, parla prima di “sistema vivente colletivo” – e fin qui si presume che sia ancora nel suo elemento – ma subito dopo passa a parlare di “Gaia”, come se fosse un semplice sinonimo di “sistema vivente collettivo”, mentre qui siamo passati all’immaginazione, ad un’entità mitologica che, da una parte sembra voler unificare e sostanzializzare la “Natura” (altra entità mtologica) senza dover rinnegare i pregiudizi antiteologici del positivismo, dall’altra richiama movimenti pseudimistici oggi diffusi, che non hanno certamente uno statuto scientifico. Tutto questo sia detto senza offesa e senza in alcun modo sminuire il valore ammirevole sia dell’articolo originale, sia delle puntualizzazioni di Andrea, sia delle delucidazioni di mio fratello. Vorrei per il momento fermarmi qui. Ma, con in pericolo di annoiare, mi permetto di allegare una pagina e mezzo che scrissi poco tempo fa alla Prof.ssa Pirani – docente di sociologia alla Sapienza – per puntualizzare un discorso molto interessante da lei svolto sul comportamento umano in relazione alle neuroscienze. Può darsi che possa essere utile sia per un confronto, sia per una eventuale futura possibilità di improbabili collaborazioni convergenti. Lo aggiungo qui di seguito.

Vorrei partire da questo splendido testo di Giovanni Reale, docente di filosofia antica presso l’Università Cattolica di Milano.

“Il viaggio che portò Platone alla scoperta di qualcosa si soprasensibile come necessario e indispensabile proprio per spiegare il sensibile, è quello che egli ha denominato con la splendida metafora della ‘seconda navigazione’. La quale è la sua personale ‘navigazione’, ma è anche la ‘navigazione’ che ciascuno di noi deve compiere, se vuole uscire dalle secche del materialismo e guadagnare gli orizzonti dell’intelligibile e del meta-materiale.

“Spieghiamo questo punto, che è il più importante, non solo nel contesto della filosofia platonica, ma, in un certo senso, nell’ambito di tutta la filosofia.

“Ebbene, la scoperta platonica può essere riassunta, in breve, come segue: quelle che gli uomini (e i filosofi prima di lui) credono e chiamano ‘cause delle cose’, che sono in genere cause meccaniche, naturali e materiali, non sono le ‘vere cause’, ma sono semplici ‘con-cause’. Le ‘vere cause’ non sono di natura sensibile, bensì intelligibile (ossia di natura meta-sensibile).

“Riportiamo i due esempi addotti da Platone per chiarire.

“Quale è la ‘vera causa’ per cui Socrate è andato in carcere? La spiegazione naturalistico-materialistica non è in grado di dire se non questo: Socrate è andato in carcere perché ha un corpo fatto di carne, ossa e nervi, muscoli e giunture; e questi hanno funzionamenti tali da rendere possibile la locomozione (oggi il materialismo potrebbe aggiungere ulteriori cause di natura socio-politica, psico-analitica, ecc.).

“Ma, questo, spiega soli il mezzo o lo strumento con cui Socrate è andato in carcere, non ‘la vera causa’ che è di tutt’altra natura. Infatti Socrate è andato in carcere in conseguenza della sua missione e quindi in conseguenza di una scelta morale, ossia perché credeva nella validità di valori morali, e, pertanto, per cause non materiali e non fisiche, e, quindi, meta materiali, ossia metafisiche.

“Ecco un secondo esempio. Vogliamo spiegare perché una cosa è bella? I naturalisti e i materialisti si richiamano a elementi puramente fisici, quali sono il colore, la figura e altri elementi di questo genere. Ma, ribatte Platone, queste non sono ‘vere cause’, bensì sono mezzi o con-cause, mediante cui si realizza una ulteriore causa. E’ la presenza dell’Idea di un Bello non fisico che fa sì che la forma, il colore e le parti materiali si strutturino in modo conveniente, vale a dire in modo da realizzare sensibilmente la non sensibile Idea.”

Sottolineo che la dimensione soprasensibile, così illustrata da Platone, viene detta anche “intelligibile”, il che indica una realtà che può essere colta dall’intelligenza e soltanto dall’intelligenza, anche se essa è presente nel mondo sensibile. Platone fa l’esempio dell’uguaglianza. Due cose sono uguali, ed effettivamente lo sono, ma soltanto l’intelligenza può cogliere questa realtà che è la loro uguaglianza. Siamo dunque in una dimensione che nessuno potrebbe chiamare “irreale”, e che anzi è tanto reale da essere causa di un mondo nuovo, la “freely chosen reality” di cui parla un recente filosofo. Posso vedere in natura tante forme minerali, vegetali, animali a forma semicircolare e osservarne le caratteristiche comuni. Da esse posso valutare la convenienza strutturale ed estetica di un edificio ad arco. Ed ecco che nelle dimore degli uomini si moltiplicano gli archi. Non sono gli archi una realtà? Lo sono certamente, e una realtà che ha un aspetto tangibile. Ma la causa di questa realtà tangibile è meta-sensibile, è un’idea sorta nella dimensione dell’intelligenza e formatasi nella visione meta-sensibile dell’uguaglianza delle realtà fisiche semicircolari. Come gli archi, così ogni realtà ha un aspetto soprasensibile, cioè intelligibile, che, per definizione, l’intelligenza soltanto può cogliere, ma che, non per questo, è meno reale di ciò che colgono i sensi.

Quando il grande neuro-scienziato Ramòn y Cajal disse che non credeva nell’anima perché non l’aveva mai vista sotto il bisturi, diceva una evidente assurdità. Se l’anima è qualcosa, ovviamente non può essere tagliata dal bisturi, come non può essere tagliato dal bisturi il pensiero espresso da Cajal: “Io non credo nell’anima”. E’ certo che, quando dico: “Io faccio, io credo, io capisco” esprimo cose realissime, quali sono io stesso, il mio volere, il mio intuire, il mio intelligere. Sono cose tanto reali che da esse deriva un mondo di realtà nuove, una vera “novitas rerum”, e con essa tutto il destino di una vita, con le sue scelte e le sue immense responsabilità.

Tutto questo per le neuroscienze non dovrebbe esistere perché non lo troviamo sotto il bisturi? A mio umile giudizio, se vogliamo fare un lavoro serio, dobbiamo necessariamente riabilitare nel discorso scientifico i concetti di “soprasensibile”, “intelligibile”, “intelligenza” (come sostanza, essere, ente intelligente. Perché non dire anima?), e con essi il senso immediato e ineludibile dell’io e della sua libertà. Volere a tutti i costi presumere come un dogma che la vera realtà che agisce in questi “epifenomeni” sia di natura fisico-misurabile, contraddice il dato di fatto originario della dimensione soprasensibile in cui necessariamente viviamo, anche nel momento in cui facciamo questi discorsi.

Tutto ciò non può essere nullificato da un discorso sulle origini e sull’evoluzione. Certamente Dante ha usato un’infinità di materiali e di precedenti culturali, ma questi precedenti non sono Dante e non spiegano la “Divina Commedia”. Per spiegare le “Divina Commedia” dobbiamo studiare la “Divina Commedia” e non i suoi precedenti culturali. Così per comprendere l’uomo dobbiamo prendere atto di ciò che egli è, e non degli eventuali presupposti biologici della sua esistenza.

Lei mi parla di Bergson. Ma Bergson ha voluto reagire al positivismo partendo dal pregiudizio che l’intelligenza fosse ormai squalificata per attingere il soprasensibile e il metafisico e che quindi bisognava trovare un’altra via, attraverso un’intuizione soprarazionale, che non si è mai riusciti a definire che cosa sia realmente. Con tutta la stima per Bergson, sono però persuaso che l’unica via realmente razionale che siamo obbligati a seguire è quella propria della filosofia classica e cattolica, che rivendica all’intelligenza – e non ad altre facoltà considerate senza la presenza e la preminenza dell’intelligenza – il superamento delle secche del positivismo e il conseguimento luminoso dell’ineludibile evidenza del soprasensibile.

Jacques Lacan, Julia Kristeva, Jean Baudrillard, Gilles Deleuze, Félix Guattari e Paul Virilio con il gergo astruso ci vanno giù duro, bisogna ammetterlo (Luce Irigaray, Bruno Latour non li conosco). Ciò significa solo che non andavano e non vanno presi per oro colato, ma solo come tentativi, solo come una sorta di moderna catena di montaggio di enunciati non tutti servibili… secondo me di loro romane poco, principalmente una cosa: Foucault.

ps: ai suoi tempi la dromologia dell’architetto stratega militare Paul Virilio mi sembrò una gran disciplina, ai limiti della beffa filosofica.

@FF

Una decina di anni fa ero ancora al liceo, e non seguivo molto il dibattito filosofico-scientifico. Ma ricordo invece che 4-5 anni fa Odifreddi citava Sokal in un articolo polemico verso Severino: il contenuto, se nn ricordo male, era che spesso i filosofi parlano della scienza senza avere la conoscenza necessaria per farlo. E’ un po’ il sintomo di un male italiano incurabile, che non so neanche a quanti anni fa risalga (molti, comunque, basta pensare a Croce): se non conosci Dante sei bollato come ignorante, mentre se non sai che cos’è il principio di indeterminazione di Heisenberg nessuno ci fa caso. Con questo vorrei allacciarmi a ciò che diceva Don Massimo Lapponi sulle neuroscienze. Io non sono un neuroscienziato, e devo dire che nutro qualche perplessità su alcuni modelli usati, e credo che quella di Ramòn y Cajal fosse un’affermazone viziata dal positivismo imperante. Stiamo però parlando dell’inizio del ‘900, oggi la neuroscienza e i neuroscienziati hanno fatto moltissimi passi avanti sia nelle procedure sperimentali che nella riflessione sulle stesse. Quello che a me piacerebbe, in un dibattito filosofico-scientifico sul tema, è che si sostiene ad esempio che la scienza non possa definire o indagare cose come la coscienza e l’anima, avesse anche letto e capito tutti gli articoli che hanno cercato di farli (e con tutti intendo tutti, non facendo cherry picking…). Se io in una discussione su Kant o Popper ignorassi una buona parte di ciò che hanni scritto o le riflessioni fatte da questo o quel filosofo, verrei perlomeno tacciato di incopetenza e mi verrebbe suggerito di studiare prima di aprir bocca. Non sto dicendo che i filosofi non possono fare riflessioni sulla scienza e solo gli scienziati lo possono fare in maniera scevra da errori. Porto due esempi. Telmo Pievano ha scritto una bellissima Introduzione alla fiosofia della biologia, dove la riflessione filosofica va di pari passi con la competenza della biologia evoluzionistica. Sull’altro versante invece lo scienziato Massimo Piattelli-Plamerini (a dire il vero professore di scienze cognitive in Arizona) e Jerry Fodor (filosofo) hanno pubblicato What Darwin got wrong, che è un concentrato di errori e/o di malafede. Ho avuto il piacere di vedere una presentazione di Massimo Piattelli-Plamerini a stdenti di dottorato che l’hanno semplicemente annichilito, semplicemente facendo domande di buon senso e ricordando dati pubblicati e accettati dalla comunità scientifica.

Credo che la scienza necessiti di una riflessione su quello che fa, ed è un bene che anche non scienziati lo facciano, da soggetti esterni spesso si vedono le cose meglio di chi è all’interno. Senza dimenticare che la scienza si basa su basi sperimentali che non possono venire ignorate o sapientamente dimenticate perchè non supportano la propria tesi.

Graziei Andrea

anche se, ti confesserò che da quando ho letto venticinque anni fa la struttura delle rivoluzioni scientifiche di Thomas Kuhn (a sua volta in circolo da una ventina d’anni prima) faccio fatica a considerare il mondo delle scienze dure come monolitico e pacificato. Per quanto riguarda il dibattito odierno rimango spesso perplesso di fronte a delle vulgate che invece di avvicinare il lettore non “averti” alla complessità di certe materie, lo coccola in semplificazioni e in bignamini dello spirito che lasciano il lettore in un’ignoranza ben peggiore. Per la filosofia valga su tutti l’esempio di certe derive alla Onfray poco più o poco meno di un Luciano de Crescenzo e salutato dai più come un nouveau philosophe. Ben vengano allora aperture come questa modesta e appassionante riflessione su NI, ( il nostro Antonio Sparzani, da buon fisico, da questo punto di vista sta svolgendo da anni un lavoro considerevole) che grazie a tutti quanti gli intervenuti finora, ha avuto luogo

effeffe

Concordo in pieno su quanto scrive Andrea. Purtroppo la mia formazione scientifica è molto carente. Però per quanto riguarda le neuroscienze ho avuto occasione di approfondirne alcuni aspetti e ho trovato molto interessanti – naturalmente, si dirà – gli scritti di John Eccles. Una decina e più di anni fa mi impegnai seriamente a scrivere una “finta” tesi di laurea in psicologia – finta perché costituiva l’appendice di un romanzetto, in cui si parlava a lungo di questa tesi, ma, tranne i manoscritti da cui prende spunto, che sono inventati, tutti gli altri dati sono perfettamente scientifici – nella quale facevo un tentativo molto serio di “definire o indagare cose come la coscienza e l’anima” dal punto di vista della scienza in un dialogo costruttivo con la filosofia e la teologia. Mi piacerebbe allegare questo lavoretto (che mi costò tre anni di studio), ma non so come fare, essendo un po’ handicappato in informatica.

Michel Chasles, eminente matematico francese membro dell’Accademia delle Scienza e della Royal Society, contemporaneo e inconsapevole studioso in parallelo della stessa geometria di cui si occupava August Fernad Möebius, – il campo di studi in cui si alloca la geometria del DNA – venne abilmente raggirato da un malefico falsario, e nel luglio del 1867 presentò all’Accademia una serie di lettere inedite attribuite a Blaise Pascal. L’episodio ci viene in parte così narrato da Marc Bloch, appassionata figura della storiografia critica e comparativa del 900:

“Un bel giorno Vrain-Denis Lucas produsse una lettera nella quale Galileo, scrivendo a Pascal si lamentava che la sua vista andasse progressivamente peggiorando. Qualcuno se ne stupì. Documenti incontrovertibili non attestavano che Galileo era diventato completamente cieco qualche anno prima della nascita di Pascal? Pensate che Vrain-Lucas si preoccupò per così poco? Si mise al tavolo da lavoro – o, per meglio dire, al bancone di lavoro – e qualche giorno dopo produsse un nuovo autografo dal quale risultava che Galileo, perseguitato, si era fatto passare per cieco senza esserlo. E’ il falso a generare il falso.”

Marc Bloch, 1941, 3 anni prima di essere torturato e ucciso dalla Gestapo.

Michel Chasles si disperò di essersi fatto ingannare in tale modo. Era si un uomo di scienza, ma pochissimo istruito di storia.

Nell’attualità caotica e schizoide del XXI secolo, nella società mediatica e silicizzata, nel mondo della comunicazione ipertrofizzata si trova di tutto, compresa la divulgazione “a grana grossa”, come ammonisce Ignazio Licata. E se i falsari – un po’ per celia un po’ per non morir – sono dislocati ovunque nella storia, l’affaire Bricmont Soka è una brillante dimostrazione che si può – in questo caso per celia – manipolare abilmente i linguaggi, proprio e soprattutto oggi, quando sul finire del 900 “everything is broken up and dances”.

Il potente e rapidissimo condizionamento della trasformazione digitale investe tutti i campi delle attività umane, intellettuali e tecnologiche. Nonostante ottimi scienziati e ottimi laboratori (a parte l’anomalia italiana) appare necessario un profondo ripensamento sul senso e sulla metodologia, che si presenta come invito a una visione non riduzionista e multidisciplinare del sistema vivente generale del pianeta. Un’apertura mentale cioè che introduca la “coscienza” nelle scienze della vita in compagnia di un confronto con tutte le culture umane, come auspica appunto Varela. E’ un problema difficile, ma non ce ne possiamo sentire esentati.

Anche se si è rinchiusi nella Torre d’avorio (oggettivista, peut-être) ove avrebbe voluto dimorare Flaubert, ci si può e ci si deve sentire al sicuro.

Mi sembrano sempre molto stimolanti gli interventi di Paolo, sia quelli relativi alle incognite di una tecnologia “dura” globalizzata, sia quelle sulla ipertrofia dell’informazione digitalizzata, anche se non sono in grado di seguire fino in fondo le argomentazioni biologiche e le eventuali imprecisioni. Osservo soltanto che il superamento della “soglia” – giustissima indicazione – potrebbe verificarsi anche in una eccessiva o male intesa “scienza della complessità”. Per questo mi sembra opportuno non perdere mai di vista anche una “scienza della semplicità”, cioè quelle evidenze primarie che sono alla base di ogni discorso, sia cognitivo, sia etico. E qui mi permetto di far notare – senza la minima presunzione o irriverenza – che, mentre è del tutto normale parlare di “filosofia della scienza”, non lo è affatto parlare di “scienza della filosofia”.